Anvendeligheten og brukervennligheten til Machine Learning-modeller testes på data. Påliteligheten til testene avhenger i stor grad av mengden og kvaliteten på dataene som disse modellene brukes på. Det er en komplett oppgave i seg selv å lage, skaffe og rense et passe stort datasett for å teste ' Naturlig språkbehandling (NLP) ' Machine Learning-modell.

Hugging Face tilbyr en ryddig løsning for dette med sitt eksepsjonelt store bibliotek med datasett å velge mellom og finne den som passer perfekt til dine behov. Her vil vi vise deg hvordan du finner det ideelle datasettet og forbereder det for å teste modellen din på en tilstrekkelig måte.

Hvordan bruke Hugging Face-datasett?

Vi vil vise deg hvordan du bruker Hugging Face-datasett ved å bruke eksemplet med ' TinyStories ” Datasett fra Hugging Face.

Eksempel

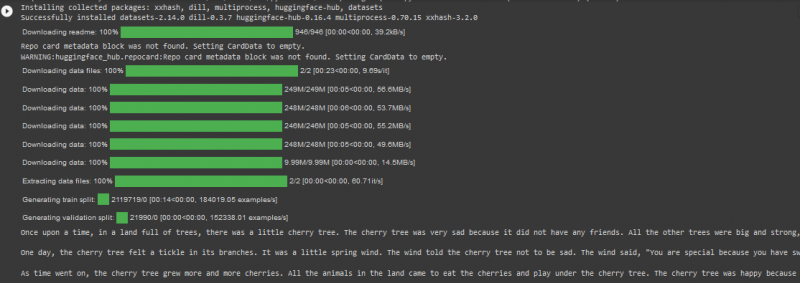

TinyStories-datasettet har mer enn 2 millioner rader med data i togdelingen, og det har mer enn 2 tusen nedlastinger på Hugging Face-plattformen. Vi vil bruke den i koden i Google Colab gitt nedenfor:

! pip installere transformatorer

! pip installere datasett

fra datasett importer load_dataset

datasett = load_dataset ( 'roneneldan/TinyStories' )

TinyStories_Story = 3

eksempelstreng = datasett [ 'tog' ] [ TinyStories_Story ] [ 'tekst' ]

skrive ut ( eksempelstreng )

I denne koden, vurder trinnene nedenfor:

Trinn 01 : Det første trinnet er ' installasjon ” av transformatordatasett.

Trinn 02 : Deretter importerer du det nødvendige datasettet, ' TinyStories ' inn i prosjektet ditt.

Trinn 03 : Deretter laster du det valgte datasettet ved å bruke ' last_datasett() ' funksjon.

Trinn 04 : Nå spesifiserer vi historienummeret vi ønsker fra TinyStories-datasettet. Vi har spesifisert tallet 03 i vårt kodeeksempel.

Trinn 05 : Til slutt vil vi bruke 'print()'-metoden for å vise utdataene.

Produksjon

Merk: Koden og utdataene kan også sees direkte i vår Google Colab .

Konklusjon

' Kommende ansikt-datasett ” gjør det utrolig effektivt for brukere å teste sine Machine Learning-modeller mens de direkte importerer store datasett fra nettbiblioteket deres. Som et resultat har anvendelsen av NLP-algoritmer blitt enklere og raskere ettersom programmerere kan få sine prosjekter testet mot et datasett som har både kvalitet og kvantitet.