Store språkmodeller eller LLM-er er en kraftig type nevrale nettverksalgoritmer for å bygge chatbots som henter data ved hjelp av kommandoer på naturlige språk. LLM-er gjør det mulig for maskiner/datamaskiner å forstå naturlig språk bedre og generere språk som mennesker. LangChain-modulen fungerer også for å bygge NLP-modeller. Den har imidlertid ikke sin LLM, men den tillater interaksjon med mange forskjellige LLM-er.

Denne veiledningen vil forklare prosessen med å samhandle med store språkmodeller ved bruk av LangChain.

Hvordan samhandle med LLMs ved hjelp av LangChain?

For å samhandle med LLM-er som bruker LangChain, følg ganske enkelt denne enkle trinnvise veiledningen med eksempler:

Installer moduler for å samhandle med LLM-er

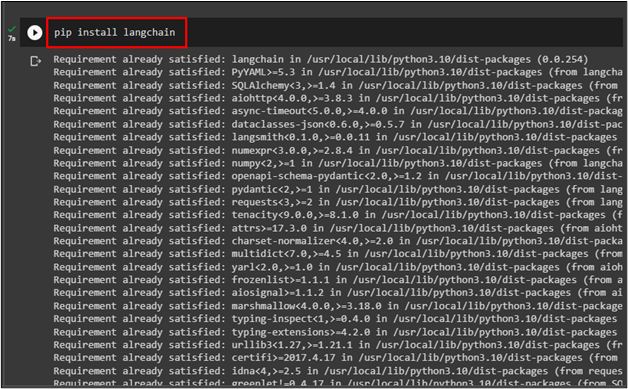

Før du starter prosessen med interaksjon med LLM-er som bruker LangChain, installer ' langkjede '-modul ved å bruke følgende kode:

pip installere langkjede

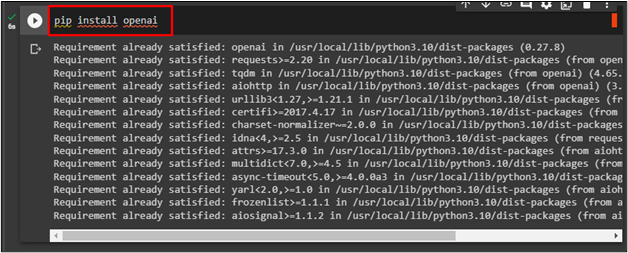

For å installere OpenAI-rammeverket, bruk API-nøkkelen for å samhandle med LLM-er via følgende kode:

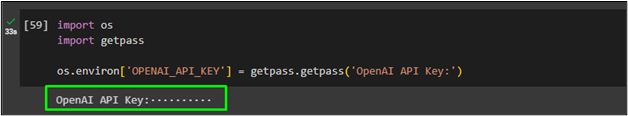

Nå, importer ' du ' og ' få pass ' for å bruke OpenAI API-nøkkelen etter å ha utført koden:

importere oss

importere getpass

os.miljø [ 'OPENAI_API_KEY' ] = getpass.getpass ( 'OpenAI API Key:' )

Ringer LLM

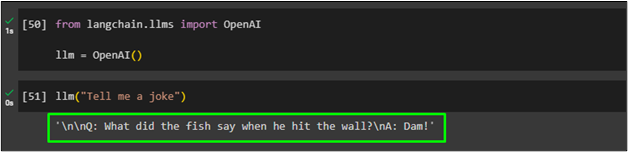

Importer OpenAI-biblioteket fra LangChain-modulen for å tilordne funksjonen til ' llm variabel:

fra langchain.llms importerer OpenAIllm = ÅpenAI ( )

Etter det ringer du bare ' llm '-funksjonen og ledetekstspørringen som parameter:

Generer flere tekster ved å bruke LLM-er

Bruk generere()-metoden med flere ledetekster på naturlig språk for å generere teksten fra LLM og lagre dem i ' llm_resultat variabel:

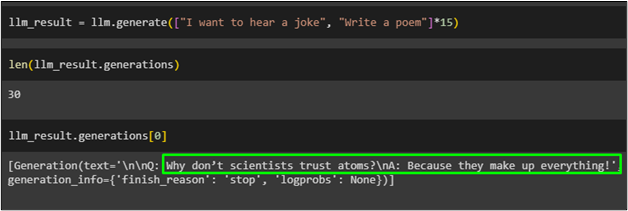

llm_result = llm.generer ( [ 'Jeg vil høre en vits' , 'Skriv et dikt' ] * femten )

Få lengden på objektene som er lagret i ' llm_resultat ' variabel ved å bruke generere() funksjonen:

Bare kall variabelen med indeksnummeret til objektene:

Følgende skjermbilde viser teksten som er lagret i ' llm_resultat variabel ved 0-indeksen som genererer vitsen:

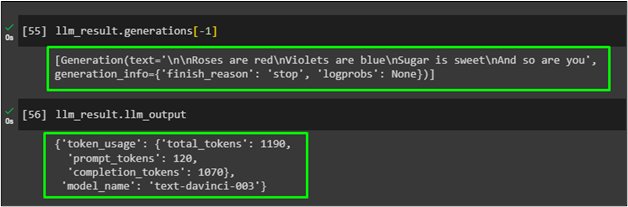

Bruk generations()-metoden med index -1 parameter for å generere diktet plassert i llm_result-variabelen:

Bare vis den genererte utgangen i resultatvariabelen for å få den leverandørspesifikke informasjonen som er generert i forrige LLM ved å bruke generert funksjon:

Det handler om å samhandle med LLM-er ved å bruke LangChain-rammeverket for å generere naturlig språk.

Konklusjon

For å samhandle med store språkmodeller ved hjelp av LangChain, installer ganske enkelt rammeverk som LangChain og OpenAI for å importere biblioteker for LLM-er. Etter det, oppgi OpenAI API-nøkkelen som skal brukes som LLM-er for å forstå eller generere det naturlige språket. Bruk LLM for input-ledeteksten på naturlig språk og kall den deretter for å generere tekst basert på kommandoen. Denne veiledningen har forklart prosessen med å samhandle med de store språkmodellene ved å bruke LangChain-moduler.