Funksjonen pipeline() er en integrert del av Transformer-biblioteket. Det krever flere innganger der vi kan definere en slutningsoppgave, modeller, tokeniseringsmekanisme osv. En pipeline()-funksjon brukes hovedsakelig til å utføre NLP-oppgaver på en eller flere tekster. Den utfører forbehandling av input og etterbehandling basert på modellen for å generere menneskelesbare utdata og nøyaktig prediksjon med maksimal nøyaktighet.

Denne artikkelen dekker følgende aspekter:

Hva er Hugging Face Dataset Library?

Et Hugging Face datasettbibliotek er et API som inneholder flere offentlige datasett og gir en enkel måte å laste dem ned på. Dette biblioteket kan importeres og installeres i applikasjonen ved å bruke ' pip ' kommando. For en praktisk demonstrasjon for å laste ned og installere datasett fra Hugging Face-biblioteket, besøk denne Google Colab-lenke. Du kan laste ned flere datasett fra Hugging Face Dataset Hub.

Lær mer om funksjonen til pipeline()-funksjonen ved å referere til denne artikkelen ' Hvordan bruke Pipeline()-funksjonen i transformatorer? '.

Hvordan bruke rørledninger på et datasett i Hugging Face?

Hugging Face gir flere forskjellige offentlige datasett som enkelt kan installeres ved å bruke én-linjes kode. I denne artikkelen vil vi se en praktisk demonstrasjon av bruk av rørledninger på disse datasettene. Det er to måter som rørledninger kan implementeres på datasettet.

Metode 1: Bruke iterasjonsmetoden

Funksjonen pipeline() kan også itereres over et datasett og en modell. For dette formålet, følg trinnene nedenfor:

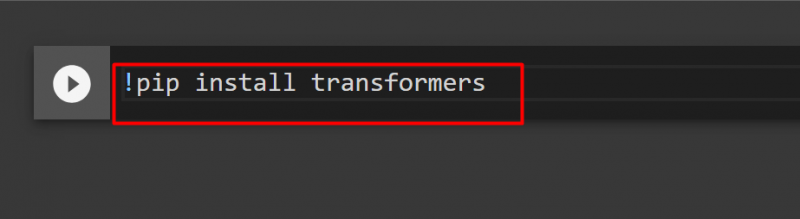

Trinn 1: Installer Transformer Library

For å installere Transformer-biblioteket, oppgi følgende kommando:

!pip installer transformatorer

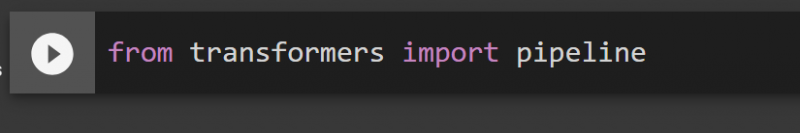

Trinn 2: Importer rørledninger

Vi kan importere rørledningen fra Transformer-biblioteket. For dette formålet, oppgi følgende kommando:

fra transformatorer import rørledning

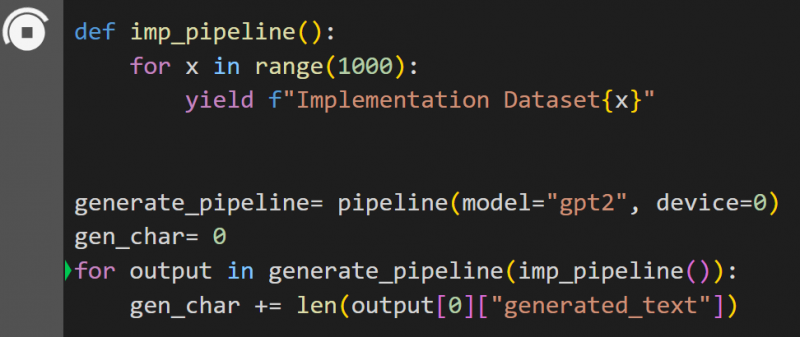

Trinn 3: Implementer Pipeline

Her er pipeline()-funksjonen implementert på modellen ' gpt2 '. Du kan laste ned modeller fra Hugging Face Model Hub:

def imp_pipeline():for x i området(1000):

yield f'Implementeringsdatasett{x}'

gener_pipeline= pipeline(model='gpt2', device=0)

gen_char= 0

for utdata i gener_pipeline(imp_pipeline()):

gen_char += len(utdata[0]['generert_tekst'])

I denne koden er ' generere_pipeline ' er en variabel som inneholder pipeline()-funksjonen med modellen ' gpt2 '. Når det kalles med ' imp_pipeline() ”-funksjonen, gjenkjenner den automatisk dataene som økes med området spesifisert til 1000:

Dette vil ta litt tid å trene. Linken til Google Co er også gitt.

Metode 2: Bruke datasettbibliotek

I denne metoden vil vi demonstrere implementering av rørledningen ved å bruke 'datasett'-biblioteket:

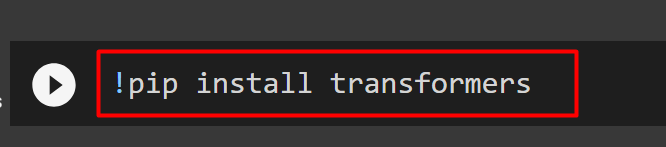

Trinn 1: Installer Transformer

For å installere Transformer-biblioteket, oppgi følgende kommando:

!pip installer transformatorer

Trinn 2: Installer Dataset Library

Som ' datasett ” biblioteket inneholder alle de offentlige datasettene, vi kan installere det ved å bruke følgende kommando. Ved å installere ' datasett ”-bibliotek, kan vi importere ethvert datasett direkte ved å oppgi navnet:

!pip installer datasett

Trinn 3: Datasettrørledning

For å bygge en pipeline på datasettet, bruk følgende kode. KeyDataset er en funksjon som bare gir ut de verdiene som interesserer brukeren:

fra transformers.pipelines.pt_utils importer KeyDatasetfra transformatorer import rørledning

fra datasett importer load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', device=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')for utdata i gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Skriver ut nå')

skrive ut ('----------------')

print (utgang)

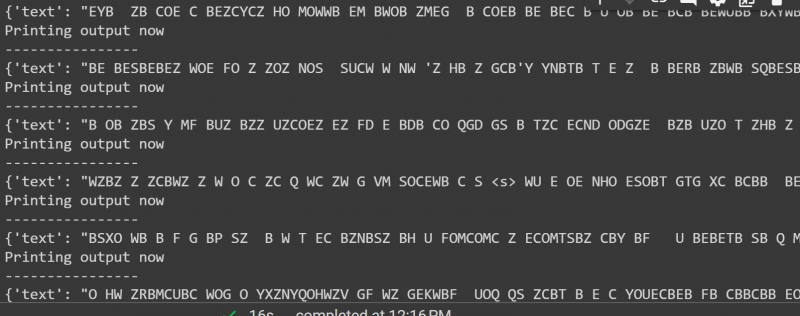

Utgangen av koden ovenfor er gitt nedenfor:

Det er alt fra denne guiden. Linken til Google Co er også nevnt i denne artikkelen

Konklusjon

For å bruke pipelines på datasettet, kan vi enten iterere over et datasett ved å bruke en pipeline()-funksjon eller bruke ' datasett ' bibliotek. Hugging Face gir GitHub-depotkoblingen til brukerne for både datasett og modeller som kan brukes basert på kravene. Denne artikkelen har gitt en omfattende veiledning for bruk av rørledninger på et datasett i Transformers.